Орудие преступления

Fri, 16 Jan 2026 08:39:30 +0300

Первый будильник прозвенел в 4:45. Второй - сразу через минуту. За ним третий, четвёртый, пятый, потом с надрывом запиликали электронные часы на стереосистеме. В 4:55 загомонили настенные часы с кукушкой и последним ровно в 5:00 тяжело загрохотал древний часовой шкаф.

— Сука! — донёсся сквозь стену истеричный мужской голос соседа жившего этажом выше, когда вся эта часовая какофония стихла. — Созон сука! Пять утра, суббота! Я тебе дверь обоссу урод, ты дождёшься!

— Да что б его разорвало! Что б он сдох! Что б ему кирпич на башку прилетел, козлу старому! Я в полицию пойду жаловаться, у меня давление! — завыл женский голос откуда-то слева после чего начались приглушённые причитания о различных женских горестях, проблемах и во всём виноватых соседях-дураках.

Спавший в кровати Созон Иванович, бывший часовой мастер, открыл глаза и прислушался.

— Кирпич, — задумчиво пробормотал он. — Шамот, керамит, силикат. Лучше бы просто камень, но с камнями столько неопределённостей. Вот и Вера Николаевна мне советует. Значит, облицовочный кирпич весом не менее четырёх килограммов.

Обдумав как следует эту мысль, он поднялся с постели, заправил её, затем в одних трусах проследовал в ванную комнату, где умылся, побрился и как следует почистил зубы. Соседка слева была не права насчёт старого козла, Созону Ивановичу было всего сорок два года. Холост, тощ, на макушке небольшая лысина, но и только. Других недостатков если не считать хронической язвы у него не имелось. А то, что он всех соседей по подъезду ни свет ни заря разбудил, так это извините, по долгу службы. Вот уже несколько лет как Созон Иванович сменил профессию и теперь работал киллером, а у них знаете ли график ненормированный. Так что может кому-то и суббота выходной, но только не ему. Ему на завтрак кефир и два банана, а затем приодеться во что почище, взять инструменты и на работу.

Нужно отметить, что киллером он был необычным. Созон Иванович не любил огнестрельное оружие, отдавая предпочтение различной импровизации. Так же он не любил повторяться, но когда всю жизнь работаешь с разной механикой, это всё равно откладывало некий профессиональный отпечаток, поэтому последние три года он каждый день боролся с самим собой. Душе постоянно хотелось чего-то новенького, а старые привычки требовали соблюдения запредельной точности. Так и жил в вечной борьбе. Может потому и не женился опасаясь рутины. Вот если бы жена каждый день была новая тогда, конечно, а так, лучше уж пусть обзывают старым козлом, зато никому ничего не должен.

Завтракая и поглядывая одним глазом на вчерашний разгаданный кроссворд он снова и снова натыкался на два слова обведённые синей ручкой. Струна и кирпич. С кирпичом было уже всё понятно, но вот струна от гитары, совершенно не подходила к делу. Клиент - важный человек, его охраняют. Подобраться близко не получится, но зато это получится у кирпича. Тогда зачем он обвёл струну в кроссворде?

Может быть придётся убивать свидетелей?

Бывший часовщик неопределённо дёрнул плечами. Кто знает. Порою он сам не знал, что выкинет в следующий раз его собственное воображение. Впрочем, оно никогда не подводило, сейчас был важен только кирпич.

Закончив завтракать, он аккуратно сложил газету и убрал её в рабочий саквояж, а когда очередные часы, коих в его квартире было более сотни, прозвенели шесть раз он вышел из дому и направился к ближайшей автобусной остановке. Сегодня, в первую очередь, он намеревался посетить строительный рынок.

*****

Скучающий сотрудник службы безопасности метро, равнодушно пропустивший старушку с большим баулом и старательно отвернувшийся при виде троих бородачей громко разговаривающих на гортанном наречии и проскользнувших через турникет по одному билету, неожиданно оживился. Приближался самый подозрительный по его профессиональному мнению человек, а именно белый мужчина средних лет в старом потёртом костюме булыжного цвета и при галстуке. В правой руке мужчина нёс тяжёлый кожаный саквояж, чьё содержимое, несомненно содержало в себе различные незаконные предметы. Срочно! Срочно проявить бдительность иначе, как бы чего не вышло.

Сотрудник безопасности храбро бросился бросился навстречу опасному незнакомцу и перехватив его у турникетов, потребовал незамедлительно пройти досмотр на рентген-аппарате. Мужчина молча отнёс саквояж куда его попросили и положил на движущуюся ленту.

— Ага! — торжествующе возликовал сотрудник вглядываясь в экран. — Что у вас в сумочке? Покажите пожалуйста.

— Нет, — отказал опасный незнакомец. — Полицию и понятых. Тогда будем производить досмотр.

"Там наверняка бомба! — обрадовался про себя сотрудник. — А может быть и запрещённые вещества. Вон, какой в сумке, кирпич здоровый".

И немедленно оповестил по рации дежурного сотрудника полиции.

*****

Полицейский Стрельцов пребывал в некотором раздражении. Снова у этих вахтёров сезонное обострение, по пустякам отвлекают. Чё орал-то? "Кирпич, кирпич!" Ну кирпич. Хороший такой, крепкий, завёрнутый в газету. Безопасники у своего рентген-аппарата, походу совсем уже в гамадрилов мутировали, на нормальных людей бросаются. Но ему всё же пришлось по долгу службы, отвлечься от чая с баранками и заняться своими прямыми обязанностями. Хорошо, что гражданин Галкин Созон Иванович изрядно облегчил ему задачу предоставив целый пакет документов начиная от паспорта и заканчивая справкой об отсутствии судимости, а то бы возился целый час, всяких важных людей беспокоил. Стрельцов отвёл мужчину в маленькое душное помещение в подземном переходе у станции, где быстренько произвёл осмотр и переписал все необходимые данные. Впрочем, некоторые моменты всё же его смущали.

— А зачем вам столько документов? — не удержавшись поинтересовался он.

— На случай если остановят, с целью уточнения личности, — невозмутимо отвечал Созон Иванович.

— Но...Права и паспорт ладно, а справка от психиатра и нарколога, да ещё и наличие отсутствия судимости и ко всему прочему медицинская книжка, многовато как-то, — озадаченно проговорил полицейский.

— Вам мало? Ещё могу предоставить загранпаспорт. Ещё у меня справки с предыдущего места работы, выписка из НДФЛ за два года и трудовая книжка. Я обожаю точность.

— И это только ради того чтобы вас в метро проверили?

Cозон Иванович с сочувствием посмотрел на полицейского.

— Обычно такой ворох документов берут, когда устраиваются на работу, — сообщил он. — Я конечно понимаю, что вы работаете в организации где не положено думать, но всё же какой-то зародыш Шерлока Холмса в вас должен присутствовать. Я иду на собеседование, в моём саквояже кирпич завёрнутый в газету, кроме того к кирпичу прилагается чек, о том, что данное изделие куплено сегодня утром на рынке в ИП Курицына. Мне очень хочется устроится на должность художника-декоратора, а этот самый кирпич, важная часть моей презентации. Очень надеюсь, что вы не задержите меня дольше чем на 24 минуты и 42 секунды.

— Чего? — нахмурился полицейский.

Мужчина показал подбородком на запястье Стрельцова.

— Я про "Ракету". Ваши наручные часы отстают на две минуты. Похоже, что грязь. Я бы их вам починил, но мне сейчас некогда. Рекомендую зайти ко мне вечером, на неделе, вот поэтому адресу. Сделаю бесплатно, — Созон Иванович протянул ему свою визитку.

Услышав про халяву полицейский тут же подобрел, за минуту закончил с бумагами и уточнив по поводу адреса, предложил провести гражданина Галкина через турникеты за-даром, в качестве компенсации. Тем более, что Созон Иванович сам сказал, что торопится. Гражданин Галкин тут же заторопился, начал беспорядочно запихивать в саквояж все свои документы и провернул это так ловко, что Стрельцов не заметил как тот уволок со стола пластиковую карту сотрудника безопасности бизнес центра "Ёлочка".

*****

Стремление не повторяться в выборе орудия преступления порою выходило ему боком. Так, несколько раз, ему приходилось отказывать выгодным заказчикам настаивавших на стандартных способах. Пистолет, нож, винтовка, но если вдуматься это же сущая ерунда. Клише. Сущий формализм. А вот вы попробуйте умертвить жертву вилкой или при помощи живого барсука? А? А? Попробуйте. А он пробовал и у него всё прекрасно получалось. Заставить жертву коснуться оголённого электрического провода под напряжением, заставить выпить полироль, убить при помощи люстры или сейфа, да и пианино, тоже помнится, в прошлом году использовал. Сосулька - была. Кость рыбья - пожалуйста и ведь всё рассчитал и даже то, что скорая помощь вовремя не успеет. А разве плоха была клиентка кушавшая в машине мороженое? Кто догадается, что это был вовсе не несчастный случай? Никто. Даже заказчик, муж покойной и то сомневался: платить или не платить за нечаянно сработавшую подушку безопасности? Но у Созона Ивановича всё было строго, как в часовой мастерской. Если заказчик не заплатил за выполненную работу, то его в чёрный список и на кладбище. Правда давненько уже таких недовольных не было, нынче все платят. Тем более как же не заплатить, когда устранение неугодного лица очень часто выглядит, как обычный несчастный случай.

Так и сегодня. Созон Иванович знал, что сотрудник безопасности проявит вопиющую бдительность граничащую с дремучим вахтёрством и знал, что у полицейского Стрельцова на столе лежит пластиковая карта из бизнес центра. Всё было рассчитано до секунды, тем более, что именно в этой "Ёлочке" у него было назначено собеседование на должность декоратора.

Когда его на входе в бизнес центр остановил очередной охранник, он нисколько не удивился и спокойненько предъявил саквояж.

Охранник пожилой мужчина в очках тут же прицепился к кирпичу. Зачем? Да почему? Нельзя сюда с кирпичами.

— Почему нельзя? Этот кирпич мне нужен для презентации, — возразил Созон Иванович.

— А вдруг вы его с крыши на кого-нибудь сбросите? Или хуже того: из окна. Нет уж вы идите себе, а кирпич тут оставьте.

— Любопытно. Как вы себе представляете этот манёвр с кирпичом на крыше? — спросил гражданин Галкин. — У вас выход на тех-этаж совершенно не охраняется и любой посторонний может туда спокойно попасть? Это же безответственно. Кто у вас начальник смены? Давайте я ему сообщу?

Охранник тут же принялся возмущаться и говорить что всё у них в порядке, а с кирпичом не положено. Что все двери закрыты не просто на замки, а ещё и на электронные, что у него тут за десять лет муха не проскользнула и что он сам себе начальник смены, а ключи только у технического персонала и ни у кого больше. Созон Иванович тут же принялся интересоваться именем отчеством охранника и на каком основании тот отказывает ему пройти с кирпичом. Охранник начал ругаться, а Созон Иванович, соответственно, звонить организации пригласившей его на собеседование. Вернее он только делал вид, что звонит, ибо главной его задачей было вызнать имя и фамилию строптивого пенсионера, каковую тот озвучил буквально за тридцать секунд. Созон Иванович был так убедителен, так напорист в выражениях, что престарелый вахтёр махнул рукой - иди мол, связываться ещё с таким говном, но если не покажешь отметку о посещении на выходе, тут-то тебе и капут.

Всё это киллер прекрасно знал, тем более, что назначенное собеседование так и не состоялось. Девушка-секретарь на четвёртом этаже удивлённо захлопала глазами и уточнила:

— Ой, а разве Казимир Ромуальдович вам не звонил? Мы подобрали себе другого кандидата, к сожалению...Извините пожалуйста за то что вам пришлось сюда ехать зазря.

Созон Иванович понимающе поохал посокрушался, а потом попросил бланк с отметкой что он побывал в офисе. А то там внизу такие злые охранники. Без зубов, а гавкают. Соблаговолите предоставить для них доказательство о том что я у вас был. Спасибо.

*****

Вся эта суета была нужна была только для отвода глаз. Настоящая же работа намечалась непосредственно на крыше бизнес центра. Ну а как туда попасть? Во-первых имеется электронный ключ-карта. А во вторых имя и фамилия сторожевого вахтёра. А зачем киллеру его имя? Подумаешь, какой-то старичок. Другой бы киллер, наверное потратил кучу своего времени, изготовил бы дубликаты ключей, возился бы с отмычками, чтобы открыть нужные двери, но зачем? Охранник же сам сказал, что ключи у технического персонала. Нужно просто найти уборщицу. Созон Иванович так и сделал. На десятом этаже он обнаружил женщину восточной внешности активно намывающую полы в коридоре и сообщил ей что старый хрыч Крынкин Анатолий Степанович, который сидит внизу, не пожелал дать ключи от тех-этажа для инженера систем вентиляции, а сказал взять у неё. У уборщицы. У неё мол, всё есть.

Та сразу всё поняла и помянув вслух осла и шайтана, коим по её мнению являлся Крынкин, доверчиво выдала нужные ключи. Правда она взяла с Галкина обещание, что закончив работать тот занесёт ей их обратно, а охранник, Анатолий Степанович, пошёл он нахуй и если ему надо, то пусть сам за ними и бегает. Созон Иванович конечно же пообещал, но уже будучи в лифте, поднимаясь на самый верхний этаж, ему пришлось вновь вступить в борьбу с самим собой. Клише. Очередное клише. Всем известно, что самые важные ключи в любом министерстве или пусть даже на секретном объекте всегда можно найти у местной уборщицы или слесаря. Но а что делать? Импровизировать? Предлагать уборщице секс за ключ? А в другой раз бутылку шампанского? Ну уж нет, с такими моментами нужно мириться, это как с временами года. Зима, весна, лето, осень - смирись Созон Иванович. Некоторые ситуации всегда одинаковы.

*****

Дверь с электронным замком. Вот и карточка пригодилась. Ещё одна дверь с обычным ключом, подошёл ключ, спасибо уборщице. Решётка - вот, ещё ключик. А самая верхняя что запирала небольшую будку на крыше так и вовсе была на задвижке. Ну а кто тут что украдёт с пятнадцатого этажа? Созон Иванович прогулялся по крыше, осмотрел окрестности, а потом его взгляд переместился на соседнюю многоэтажку. Она была выше бизнес-центра "Ёлочка" на семь этажей. Красивое блестящее здание из стекла и бетона. Замечательно. А клиент, тот которого он должен умертвить, придёт подписывать важные бумаги, вон туда. На третий этаж. Любопытно, можно ли метнуть кирпич так, чтобы он навесиком прилетел прямо в окно и попал клиенту прямо в хлебало?

Созон Иванович посмотрел на небо, прищурившись мельком глянул на солнце и тут же зажмурился ибо обжигало по летнему. Потом он послюнявил указательный палец и поднял вверх. Слабый "Зюйд-Вест" 2-3 метра в секунду. Это хорошо. Можно делать катапульту. В качестве катапульты выступали толстый рулон рубероида и длинная крепкая доска. Постороннему человеку могло показаться, что он занимается совершенной глупостью, но именно таков Созон Иванович, потому как обожал сложные и трудновыполнимые задачи. У него будет только одна попытка и ему её будет вполне достаточно. Со слов заказчика, если клиент подпишет бумаги, то в услугах Созона Ивановича более не будет нужды. А это значит провал. Фиаско. Один шанс из десятков тысяч. Какова вероятность, что кирпич прилетит куда надо и в нужный момент? А она необычайно мала, но что поделать, хе-хе, ради таких моментов и живём. Не убийства ради и уж тем более не ради прибыли. Азарт - вот чего душеньке хотелось. Тем более, что последний момент зависел исключительно от заказчика. Ведь он должен был позвонить и предупредить, когда именно клиент войдёт в офис. А вдруг он не позвонит? А вдруг ещё чего? Связь пропадёт например?

Киллер кружился на крыше раз за разом перепроверяя свои расчёты. Нет, не долетит кирпич, нужно подвинуть край доски. А так? Вроде уже получше. Чего же заказчик не звонит? Время-то почти, подходящее. Десять утра. В самый раз для подписания документов. Можно конечно было бы попробовать запульнуть кирпич в тот момент, когда тот будет выходить из автомобиля, но это слишком просто. Он уже проверил. В окно попасть будет гораздо сложнее. А если он оступится или приложит недостаточно усилий? Ах, как же хорошо. Какое приятное томление. В миллион раз лучше чем обливаясь потом часами лежать в грязи и пялиться в прицел снайперской винтовки. Тут делов-то, прыгнул на доску и всё, а дальше, в дело вступят законы Ньютона.

В кармане зазвонил телефон. Созон Иванович обрадовался ещё сильнее.

— Алло?

— Созон Иванович? Очень рад нашему знакомству. За вами так забавно наблюдать.

Голос был незнакомый. Киллер насторожился и машинально посмотрел на номер. Не тот. Звонили с постороннего номера.

— Позвольте представиться, — продолжил говорить голос. — Я ангел-хранитель.

— Что-что? — озадаченно переспросил Созон. — Откуда у вас мой номер?

— А вы догадайтесь, — ехидно посоветовали ему. — Вы же гениальный убийца и не побоюсь этого слова - мастер своего дела. Честно говоря, не могу скрыть своего восхищения от знакомства с вами. Давно мечтал. А теперь вы у меня на прицеле.

— Не понимаю вас, кажется тут какая-то ошибка. Я обычный художник декоратор, — Созон Иванович закрутился на одном месте пытаясь определить вероятное местоположение снайпера.

— Я на крыше здания в которое вы собираетесь кирпичами кидаться, — подсказал ему голос. — Что вы там такое изобрели? Качели?

— Это катапульта, — непроизвольно обиделся Созон Иванович.

— О. А метать снаряды будете в сторону главного входа? Так и знал, что вы постараетесь убить моего протеже в момент его максимальной беззащитности. Он значит из машины выйдет, а ему кирпич по голове сверху - тюк!

— Кто вы такой и чего вам надо?

— Не боись, твоя смерть мне не интересна, — снисходительно сообщил голос. — Я, с вашего позволения, сразу на ты, для большего доверия, хорошо? В общем, я хочу чтобы ты промазал. А вот если откажешься, тогда пристрелю.

Созон Иванович почувствовал как у него краснеют уши.

— Понятно, конкурент значит, — догадался он.

— Ещё какой, — ехидно подтвердил голос. — Я уже знаешь ли, подсуетился. Клиент подпишет бумаги и ты этому никак не помешаешь. Более того, он едет сюда на бронированном автомобиле, но подъедет не к главному входу, а с другой стороны и заедет на подземную парковку. Но самое интересное: встреча будет проходить не на том этаже на котором ты планировал. Так что тебе осталось всего ничего. Ну ты догадался уже, да? Прыгаешь на доску и успешно метаешь кирпич куда бог пошлёт.

Созон Иванович понял, что его загнали в ловушку. Деваться ему было совершенно некуда.

— Тогда может, я просто уйду? — попросил он. — К чему эти глупости?

— Ну как же, ты же так старался. Я, прости, не могу лишить тебя такой радости. Только перед тем как будешь прыгать не забудь сказать: "Орех, орех - на кого укажет грех", — на той стороне трубки кто-то явственно захихикал. Затем послышались щелчки показавшиеся Галкину отчего-то знакомыми и голос продолжил:

— Меня всегда поражала твоя изобретательность, Созон, каждый раз новые способы, а между тем, тебе всё чаще и чаще достаются самые жирные заказы и я всё думал, это удача или что? Ну не может человек рассчитать, как ты сейчас, с кирпичом. Тут взрывчатку бывает, подбираешь строго до десятой доли грамма и всё равно, ошибаешься, каждую детальку по сто раз проверяешь прежде чем в дело пустить, а ты... Ведь каждый раз на импровизации выезжаешь. Как ты допёр, что тот клиент, которого ты ранил ножницами, умрёт в больнице от заражения крови? А тот случай с депутатом защищавшим бродячих собак, их же проверяли специально обученные ветеринары, как так вышло что ты подослал ему дворнягу заражённую бешенством? Это удача, мистика, предвиденье? Я не понимаю!

— Это наука. Физике надо было в школе учиться, в своё время, а не всякую похабщину в учебниках рисовать, — тихо ответил Созон Иванович.

— А вот сейчас и проверим, твою науку, — злорадно пообещал голос и приказал:

— Поворачивай свою катапульту.

*****

Созон Иванович был уверен, что загадочный киллер убъёт его после того, как тот выполнит его приказание и потому, он, сразу как только прыгнул на доску и отправил в полёт кирпич, метнулся в сторону и специально упал плашмя прижавшись животом и головой к липкой кровле. По его быстрым расчётам именно там находилось слепое пятно образовавшееся вследствие небольшого перепада высот на крыше. При этом он так и не сбросил звонок и продолжал держать телефон в правой руке. Он хотел услышать как киллер начнёт ругаться, а затем ему придётся бросить свою точку и идти искать новую, что позволило бы выиграть время для побега. И неизвестный действительно начал ругаться, а потом произошло то, чего Созон Иванович действительно не мог предсказать.

Загрохотало. Он едва не оглох.

Созон Иванович было подумал, что киллер решил с ним не церемониться и применил гранатомёт, но когда перевернулся на спину увидел, что из-за края крыши вверх поднимается купол воздушного шара. И выглядело это необычайно зловеще поскольку цвет у воздушного шара был странный: чёрный пополам с красным и во все стороны от него летели жирные хлопья сажи. Только спустя мгновение показавшееся ему вечностью до него дошло, что это вовсе не шар, а дымная шапка появившаяся в результате сильного взрыва. А спустя другое мгновение, он понял что это его шанс выжить ибо огненно-дымная туча отделила одно здание от другого и сейчас, самое время было драпать.

— Твою мать! Созон! Это всё ты! Что ты сделал, сука!

Это очнулся в руке телефон, но Созон не слушал, он торопился добежать до спасительной будки откуда нырнул на лестницу, спустился, внизу подобрал свой саквояж и уже там, отдышавшись, сбросил звонок. Несколько успокоившись, он собрал в кулак всю свою волю и принялся устранять все возможные следы своего пребывания на тех-этаже. Все двери были тщательно закрыты, а ключи он отнёс уборщице как и обещал, после чего посетил туалет где почистился, умылся, проверил пропуск и нацепив самое равнодушное лицо отправился в вестибюль. Скрываться не имело никакого смысла. Ангел-хранитель знает его в лицо, а вот он про него ничего не знает. Зато теперь все будут знать, что Созон промазал. Так что же теперь делать? Уезжать из города? А может снова в часовщики? Опыт-то не пропьёшь. Но как же по-детски обидно. Опозорили. И кто? Ладно бы менты, но свои же...Да какие они свои, обычные гомосеки-завистники.

С этими мыслями он добрался до первого этажа где заметил метавшегося в дверях старика вахтёра. Тот очень хотел покинуть свой пост, хотел кому-то звонить и даже бежать за огнетушителем, а ещё у каждого входящего он с жаром интересовался - ну, что там?!!

Действительно, что там? Созон бросил вахтёру пропуск и миновав турникет очутился в дверях, откуда начиналась толпа любопытных и зевак наблюдавших за тем как на другой стороне улицы горит бензовоз, автобус и ещё какая-то длинная машина издали похожая на лимузин. Движение на улице было остановлено в обе стороны. Ревели пожарные машины, кто-то наглый пытался под шумок проехать почти вплотную к огню. Полицейские не успевали свистеть и выписывать штрафы.

— С эстакады бензовоз упал, — уверенно говорил кто-то.

— Так эстакада вон где, как он тут оказался? — возражали в толпе.

— Сам видел, он упал и проехал ещё на скорости, а потом в автобус вписался а автобус боком, вон в ту тачку. И как полыхнёт!

— Там живых точно не осталось.

— Пиздец, а не смерть.

Созон Иванович поглядел в сторону эстакады и похолодел от страха. Вот оно, то самое. "Орех, орех - на кого укажет грех". Грёбаный киллер. Кирпич угодил в бензовоз, тот резко свернул и упал вниз, а потом произошла детонация. Ну, тут уже следствие будет в точности разбираться. А ему уже ничего не остаётся. Только наверное, уезжать.

Протолкавшись сквозь толпу он побрёл вниз по улице, хмуро поглядывая на своё отражение мелькавшее в магазинных витринах. Какая же у него отвратительная рожа. Особенно вот тут у зеркальной витрины магазина музыкальных инструментов. Не человек, а чёрт. Скорее бы уже в ад забрали, а то на земле даже киллеры и те над ним потешаются.

Не отдавая себе отчёта он открыл дверь и зашёл в магазин где стал бесцельно бродить между стеллажей с инструментами. Мрачный молодой продавец с кольцом в носу, поглядывал на него словно кошка на ворону. Ходит туда сюда и чего спрашивается ходит?

— Может вы местом ошиблись? — предположил он. — Магазин "Шестёрочка", через два дома.

В этот момент в кармане у Галкина булькнул телефон оповещая о принятом сообщении. Подслеповато щурясь, Созон Иванович прочитал сообщение и горестно застонал.

— Здесь не аптека, — предупредил продавец. — У нас инструменты.

— Знаю... Струна для гитары, — пряча глаза отрешённо пробормотал Созон. — Какие бывают струны?

— Всякие. Ми, Си, Соль, Ре, Ля, — сказал продавец. — Вам на какую гитару?

— Ля? Как мило. Дайте мне струну, ля, — попросил Созон.

— Только одну?

— Да. Мне хватит. И ещё вон те перчатки, они с виду крепкие.

Разжившись гитарной струной и перчатками барабанщика он вышел на улицу. Отступать более не имело смысла. Нужно идти охотиться на киллера. И причин этому было две. Первая - заказчик перевёл деньги за клиента, а это значит что клиент мёртв и то что от него осталось сейчас догорает неподалёку от бензовоза, а вторая... Он вспомнил про щелчки во время телефонного разговора с неизвестным. Это часы. Причём необычайно редкая модель Кайзер с циферблатом в виде солнечной системы. Он наверняка где-то тут. Шныряет в толпе. Вот по часам-то Созон его и вычислит. Ничего, ничего страшного. Задача трудная, но ради таких трудных задач он и живёт, а иначе и жить незачем.

-----------

автор Василий Кораблев

Fri, 16 Jan 2026 08:39:30 +0300

Первый будильник прозвенел в 4:45. Второй - сразу через минуту. За ним третий, четвёртый, пятый, потом с надрывом запиликали электронные часы на стереосистеме. В 4:55 загомонили настенные часы с кукушкой и последним ровно в 5:00 тяжело загрохотал древний часовой шкаф.

— Сука! — донёсся сквозь стену истеричный мужской голос соседа жившего этажом выше, когда вся эта часовая какофония стихла. — Созон сука! Пять утра, суббота! Я тебе дверь обоссу урод, ты дождёшься!

— Да что б его разорвало! Что б он сдох! Что б ему кирпич на башку прилетел, козлу старому! Я в полицию пойду жаловаться, у меня давление! — завыл женский голос откуда-то слева после чего начались приглушённые причитания о различных женских горестях, проблемах и во всём виноватых соседях-дураках.

Спавший в кровати Созон Иванович, бывший часовой мастер, открыл глаза и прислушался.

— Кирпич, — задумчиво пробормотал он. — Шамот, керамит, силикат. Лучше бы просто камень, но с камнями столько неопределённостей. Вот и Вера Николаевна мне советует. Значит, облицовочный кирпич весом не менее четырёх килограммов.

Обдумав как следует эту мысль, он поднялся с постели, заправил её, затем в одних трусах проследовал в ванную комнату, где умылся, побрился и как следует почистил зубы. Соседка слева была не права насчёт старого козла, Созону Ивановичу было всего сорок два года. Холост, тощ, на макушке небольшая лысина, но и только. Других недостатков если не считать хронической язвы у него не имелось. А то, что он всех соседей по подъезду ни свет ни заря разбудил, так это извините, по долгу службы. Вот уже несколько лет как Созон Иванович сменил профессию и теперь работал киллером, а у них знаете ли график ненормированный. Так что может кому-то и суббота выходной, но только не ему. Ему на завтрак кефир и два банана, а затем приодеться во что почище, взять инструменты и на работу.

Нужно отметить, что киллером он был необычным. Созон Иванович не любил огнестрельное оружие, отдавая предпочтение различной импровизации. Так же он не любил повторяться, но когда всю жизнь работаешь с разной механикой, это всё равно откладывало некий профессиональный отпечаток, поэтому последние три года он каждый день боролся с самим собой. Душе постоянно хотелось чего-то новенького, а старые привычки требовали соблюдения запредельной точности. Так и жил в вечной борьбе. Может потому и не женился опасаясь рутины. Вот если бы жена каждый день была новая тогда, конечно, а так, лучше уж пусть обзывают старым козлом, зато никому ничего не должен.

Завтракая и поглядывая одним глазом на вчерашний разгаданный кроссворд он снова и снова натыкался на два слова обведённые синей ручкой. Струна и кирпич. С кирпичом было уже всё понятно, но вот струна от гитары, совершенно не подходила к делу. Клиент - важный человек, его охраняют. Подобраться близко не получится, но зато это получится у кирпича. Тогда зачем он обвёл струну в кроссворде?

Может быть придётся убивать свидетелей?

Бывший часовщик неопределённо дёрнул плечами. Кто знает. Порою он сам не знал, что выкинет в следующий раз его собственное воображение. Впрочем, оно никогда не подводило, сейчас был важен только кирпич.

Закончив завтракать, он аккуратно сложил газету и убрал её в рабочий саквояж, а когда очередные часы, коих в его квартире было более сотни, прозвенели шесть раз он вышел из дому и направился к ближайшей автобусной остановке. Сегодня, в первую очередь, он намеревался посетить строительный рынок.

*****

Скучающий сотрудник службы безопасности метро, равнодушно пропустивший старушку с большим баулом и старательно отвернувшийся при виде троих бородачей громко разговаривающих на гортанном наречии и проскользнувших через турникет по одному билету, неожиданно оживился. Приближался самый подозрительный по его профессиональному мнению человек, а именно белый мужчина средних лет в старом потёртом костюме булыжного цвета и при галстуке. В правой руке мужчина нёс тяжёлый кожаный саквояж, чьё содержимое, несомненно содержало в себе различные незаконные предметы. Срочно! Срочно проявить бдительность иначе, как бы чего не вышло.

Сотрудник безопасности храбро бросился бросился навстречу опасному незнакомцу и перехватив его у турникетов, потребовал незамедлительно пройти досмотр на рентген-аппарате. Мужчина молча отнёс саквояж куда его попросили и положил на движущуюся ленту.

— Ага! — торжествующе возликовал сотрудник вглядываясь в экран. — Что у вас в сумочке? Покажите пожалуйста.

— Нет, — отказал опасный незнакомец. — Полицию и понятых. Тогда будем производить досмотр.

"Там наверняка бомба! — обрадовался про себя сотрудник. — А может быть и запрещённые вещества. Вон, какой в сумке, кирпич здоровый".

И немедленно оповестил по рации дежурного сотрудника полиции.

*****

Полицейский Стрельцов пребывал в некотором раздражении. Снова у этих вахтёров сезонное обострение, по пустякам отвлекают. Чё орал-то? "Кирпич, кирпич!" Ну кирпич. Хороший такой, крепкий, завёрнутый в газету. Безопасники у своего рентген-аппарата, походу совсем уже в гамадрилов мутировали, на нормальных людей бросаются. Но ему всё же пришлось по долгу службы, отвлечься от чая с баранками и заняться своими прямыми обязанностями. Хорошо, что гражданин Галкин Созон Иванович изрядно облегчил ему задачу предоставив целый пакет документов начиная от паспорта и заканчивая справкой об отсутствии судимости, а то бы возился целый час, всяких важных людей беспокоил. Стрельцов отвёл мужчину в маленькое душное помещение в подземном переходе у станции, где быстренько произвёл осмотр и переписал все необходимые данные. Впрочем, некоторые моменты всё же его смущали.

— А зачем вам столько документов? — не удержавшись поинтересовался он.

— На случай если остановят, с целью уточнения личности, — невозмутимо отвечал Созон Иванович.

— Но...Права и паспорт ладно, а справка от психиатра и нарколога, да ещё и наличие отсутствия судимости и ко всему прочему медицинская книжка, многовато как-то, — озадаченно проговорил полицейский.

— Вам мало? Ещё могу предоставить загранпаспорт. Ещё у меня справки с предыдущего места работы, выписка из НДФЛ за два года и трудовая книжка. Я обожаю точность.

— И это только ради того чтобы вас в метро проверили?

Cозон Иванович с сочувствием посмотрел на полицейского.

— Обычно такой ворох документов берут, когда устраиваются на работу, — сообщил он. — Я конечно понимаю, что вы работаете в организации где не положено думать, но всё же какой-то зародыш Шерлока Холмса в вас должен присутствовать. Я иду на собеседование, в моём саквояже кирпич завёрнутый в газету, кроме того к кирпичу прилагается чек, о том, что данное изделие куплено сегодня утром на рынке в ИП Курицына. Мне очень хочется устроится на должность художника-декоратора, а этот самый кирпич, важная часть моей презентации. Очень надеюсь, что вы не задержите меня дольше чем на 24 минуты и 42 секунды.

— Чего? — нахмурился полицейский.

Мужчина показал подбородком на запястье Стрельцова.

— Я про "Ракету". Ваши наручные часы отстают на две минуты. Похоже, что грязь. Я бы их вам починил, но мне сейчас некогда. Рекомендую зайти ко мне вечером, на неделе, вот поэтому адресу. Сделаю бесплатно, — Созон Иванович протянул ему свою визитку.

Услышав про халяву полицейский тут же подобрел, за минуту закончил с бумагами и уточнив по поводу адреса, предложил провести гражданина Галкина через турникеты за-даром, в качестве компенсации. Тем более, что Созон Иванович сам сказал, что торопится. Гражданин Галкин тут же заторопился, начал беспорядочно запихивать в саквояж все свои документы и провернул это так ловко, что Стрельцов не заметил как тот уволок со стола пластиковую карту сотрудника безопасности бизнес центра "Ёлочка".

*****

Стремление не повторяться в выборе орудия преступления порою выходило ему боком. Так, несколько раз, ему приходилось отказывать выгодным заказчикам настаивавших на стандартных способах. Пистолет, нож, винтовка, но если вдуматься это же сущая ерунда. Клише. Сущий формализм. А вот вы попробуйте умертвить жертву вилкой или при помощи живого барсука? А? А? Попробуйте. А он пробовал и у него всё прекрасно получалось. Заставить жертву коснуться оголённого электрического провода под напряжением, заставить выпить полироль, убить при помощи люстры или сейфа, да и пианино, тоже помнится, в прошлом году использовал. Сосулька - была. Кость рыбья - пожалуйста и ведь всё рассчитал и даже то, что скорая помощь вовремя не успеет. А разве плоха была клиентка кушавшая в машине мороженое? Кто догадается, что это был вовсе не несчастный случай? Никто. Даже заказчик, муж покойной и то сомневался: платить или не платить за нечаянно сработавшую подушку безопасности? Но у Созона Ивановича всё было строго, как в часовой мастерской. Если заказчик не заплатил за выполненную работу, то его в чёрный список и на кладбище. Правда давненько уже таких недовольных не было, нынче все платят. Тем более как же не заплатить, когда устранение неугодного лица очень часто выглядит, как обычный несчастный случай.

Так и сегодня. Созон Иванович знал, что сотрудник безопасности проявит вопиющую бдительность граничащую с дремучим вахтёрством и знал, что у полицейского Стрельцова на столе лежит пластиковая карта из бизнес центра. Всё было рассчитано до секунды, тем более, что именно в этой "Ёлочке" у него было назначено собеседование на должность декоратора.

Когда его на входе в бизнес центр остановил очередной охранник, он нисколько не удивился и спокойненько предъявил саквояж.

Охранник пожилой мужчина в очках тут же прицепился к кирпичу. Зачем? Да почему? Нельзя сюда с кирпичами.

— Почему нельзя? Этот кирпич мне нужен для презентации, — возразил Созон Иванович.

— А вдруг вы его с крыши на кого-нибудь сбросите? Или хуже того: из окна. Нет уж вы идите себе, а кирпич тут оставьте.

— Любопытно. Как вы себе представляете этот манёвр с кирпичом на крыше? — спросил гражданин Галкин. — У вас выход на тех-этаж совершенно не охраняется и любой посторонний может туда спокойно попасть? Это же безответственно. Кто у вас начальник смены? Давайте я ему сообщу?

Охранник тут же принялся возмущаться и говорить что всё у них в порядке, а с кирпичом не положено. Что все двери закрыты не просто на замки, а ещё и на электронные, что у него тут за десять лет муха не проскользнула и что он сам себе начальник смены, а ключи только у технического персонала и ни у кого больше. Созон Иванович тут же принялся интересоваться именем отчеством охранника и на каком основании тот отказывает ему пройти с кирпичом. Охранник начал ругаться, а Созон Иванович, соответственно, звонить организации пригласившей его на собеседование. Вернее он только делал вид, что звонит, ибо главной его задачей было вызнать имя и фамилию строптивого пенсионера, каковую тот озвучил буквально за тридцать секунд. Созон Иванович был так убедителен, так напорист в выражениях, что престарелый вахтёр махнул рукой - иди мол, связываться ещё с таким говном, но если не покажешь отметку о посещении на выходе, тут-то тебе и капут.

Всё это киллер прекрасно знал, тем более, что назначенное собеседование так и не состоялось. Девушка-секретарь на четвёртом этаже удивлённо захлопала глазами и уточнила:

— Ой, а разве Казимир Ромуальдович вам не звонил? Мы подобрали себе другого кандидата, к сожалению...Извините пожалуйста за то что вам пришлось сюда ехать зазря.

Созон Иванович понимающе поохал посокрушался, а потом попросил бланк с отметкой что он побывал в офисе. А то там внизу такие злые охранники. Без зубов, а гавкают. Соблаговолите предоставить для них доказательство о том что я у вас был. Спасибо.

*****

Вся эта суета была нужна была только для отвода глаз. Настоящая же работа намечалась непосредственно на крыше бизнес центра. Ну а как туда попасть? Во-первых имеется электронный ключ-карта. А во вторых имя и фамилия сторожевого вахтёра. А зачем киллеру его имя? Подумаешь, какой-то старичок. Другой бы киллер, наверное потратил кучу своего времени, изготовил бы дубликаты ключей, возился бы с отмычками, чтобы открыть нужные двери, но зачем? Охранник же сам сказал, что ключи у технического персонала. Нужно просто найти уборщицу. Созон Иванович так и сделал. На десятом этаже он обнаружил женщину восточной внешности активно намывающую полы в коридоре и сообщил ей что старый хрыч Крынкин Анатолий Степанович, который сидит внизу, не пожелал дать ключи от тех-этажа для инженера систем вентиляции, а сказал взять у неё. У уборщицы. У неё мол, всё есть.

Та сразу всё поняла и помянув вслух осла и шайтана, коим по её мнению являлся Крынкин, доверчиво выдала нужные ключи. Правда она взяла с Галкина обещание, что закончив работать тот занесёт ей их обратно, а охранник, Анатолий Степанович, пошёл он нахуй и если ему надо, то пусть сам за ними и бегает. Созон Иванович конечно же пообещал, но уже будучи в лифте, поднимаясь на самый верхний этаж, ему пришлось вновь вступить в борьбу с самим собой. Клише. Очередное клише. Всем известно, что самые важные ключи в любом министерстве или пусть даже на секретном объекте всегда можно найти у местной уборщицы или слесаря. Но а что делать? Импровизировать? Предлагать уборщице секс за ключ? А в другой раз бутылку шампанского? Ну уж нет, с такими моментами нужно мириться, это как с временами года. Зима, весна, лето, осень - смирись Созон Иванович. Некоторые ситуации всегда одинаковы.

*****

Дверь с электронным замком. Вот и карточка пригодилась. Ещё одна дверь с обычным ключом, подошёл ключ, спасибо уборщице. Решётка - вот, ещё ключик. А самая верхняя что запирала небольшую будку на крыше так и вовсе была на задвижке. Ну а кто тут что украдёт с пятнадцатого этажа? Созон Иванович прогулялся по крыше, осмотрел окрестности, а потом его взгляд переместился на соседнюю многоэтажку. Она была выше бизнес-центра "Ёлочка" на семь этажей. Красивое блестящее здание из стекла и бетона. Замечательно. А клиент, тот которого он должен умертвить, придёт подписывать важные бумаги, вон туда. На третий этаж. Любопытно, можно ли метнуть кирпич так, чтобы он навесиком прилетел прямо в окно и попал клиенту прямо в хлебало?

Созон Иванович посмотрел на небо, прищурившись мельком глянул на солнце и тут же зажмурился ибо обжигало по летнему. Потом он послюнявил указательный палец и поднял вверх. Слабый "Зюйд-Вест" 2-3 метра в секунду. Это хорошо. Можно делать катапульту. В качестве катапульты выступали толстый рулон рубероида и длинная крепкая доска. Постороннему человеку могло показаться, что он занимается совершенной глупостью, но именно таков Созон Иванович, потому как обожал сложные и трудновыполнимые задачи. У него будет только одна попытка и ему её будет вполне достаточно. Со слов заказчика, если клиент подпишет бумаги, то в услугах Созона Ивановича более не будет нужды. А это значит провал. Фиаско. Один шанс из десятков тысяч. Какова вероятность, что кирпич прилетит куда надо и в нужный момент? А она необычайно мала, но что поделать, хе-хе, ради таких моментов и живём. Не убийства ради и уж тем более не ради прибыли. Азарт - вот чего душеньке хотелось. Тем более, что последний момент зависел исключительно от заказчика. Ведь он должен был позвонить и предупредить, когда именно клиент войдёт в офис. А вдруг он не позвонит? А вдруг ещё чего? Связь пропадёт например?

Киллер кружился на крыше раз за разом перепроверяя свои расчёты. Нет, не долетит кирпич, нужно подвинуть край доски. А так? Вроде уже получше. Чего же заказчик не звонит? Время-то почти, подходящее. Десять утра. В самый раз для подписания документов. Можно конечно было бы попробовать запульнуть кирпич в тот момент, когда тот будет выходить из автомобиля, но это слишком просто. Он уже проверил. В окно попасть будет гораздо сложнее. А если он оступится или приложит недостаточно усилий? Ах, как же хорошо. Какое приятное томление. В миллион раз лучше чем обливаясь потом часами лежать в грязи и пялиться в прицел снайперской винтовки. Тут делов-то, прыгнул на доску и всё, а дальше, в дело вступят законы Ньютона.

В кармане зазвонил телефон. Созон Иванович обрадовался ещё сильнее.

— Алло?

— Созон Иванович? Очень рад нашему знакомству. За вами так забавно наблюдать.

Голос был незнакомый. Киллер насторожился и машинально посмотрел на номер. Не тот. Звонили с постороннего номера.

— Позвольте представиться, — продолжил говорить голос. — Я ангел-хранитель.

— Что-что? — озадаченно переспросил Созон. — Откуда у вас мой номер?

— А вы догадайтесь, — ехидно посоветовали ему. — Вы же гениальный убийца и не побоюсь этого слова - мастер своего дела. Честно говоря, не могу скрыть своего восхищения от знакомства с вами. Давно мечтал. А теперь вы у меня на прицеле.

— Не понимаю вас, кажется тут какая-то ошибка. Я обычный художник декоратор, — Созон Иванович закрутился на одном месте пытаясь определить вероятное местоположение снайпера.

— Я на крыше здания в которое вы собираетесь кирпичами кидаться, — подсказал ему голос. — Что вы там такое изобрели? Качели?

— Это катапульта, — непроизвольно обиделся Созон Иванович.

— О. А метать снаряды будете в сторону главного входа? Так и знал, что вы постараетесь убить моего протеже в момент его максимальной беззащитности. Он значит из машины выйдет, а ему кирпич по голове сверху - тюк!

— Кто вы такой и чего вам надо?

— Не боись, твоя смерть мне не интересна, — снисходительно сообщил голос. — Я, с вашего позволения, сразу на ты, для большего доверия, хорошо? В общем, я хочу чтобы ты промазал. А вот если откажешься, тогда пристрелю.

Созон Иванович почувствовал как у него краснеют уши.

— Понятно, конкурент значит, — догадался он.

— Ещё какой, — ехидно подтвердил голос. — Я уже знаешь ли, подсуетился. Клиент подпишет бумаги и ты этому никак не помешаешь. Более того, он едет сюда на бронированном автомобиле, но подъедет не к главному входу, а с другой стороны и заедет на подземную парковку. Но самое интересное: встреча будет проходить не на том этаже на котором ты планировал. Так что тебе осталось всего ничего. Ну ты догадался уже, да? Прыгаешь на доску и успешно метаешь кирпич куда бог пошлёт.

Созон Иванович понял, что его загнали в ловушку. Деваться ему было совершенно некуда.

— Тогда может, я просто уйду? — попросил он. — К чему эти глупости?

— Ну как же, ты же так старался. Я, прости, не могу лишить тебя такой радости. Только перед тем как будешь прыгать не забудь сказать: "Орех, орех - на кого укажет грех", — на той стороне трубки кто-то явственно захихикал. Затем послышались щелчки показавшиеся Галкину отчего-то знакомыми и голос продолжил:

— Меня всегда поражала твоя изобретательность, Созон, каждый раз новые способы, а между тем, тебе всё чаще и чаще достаются самые жирные заказы и я всё думал, это удача или что? Ну не может человек рассчитать, как ты сейчас, с кирпичом. Тут взрывчатку бывает, подбираешь строго до десятой доли грамма и всё равно, ошибаешься, каждую детальку по сто раз проверяешь прежде чем в дело пустить, а ты... Ведь каждый раз на импровизации выезжаешь. Как ты допёр, что тот клиент, которого ты ранил ножницами, умрёт в больнице от заражения крови? А тот случай с депутатом защищавшим бродячих собак, их же проверяли специально обученные ветеринары, как так вышло что ты подослал ему дворнягу заражённую бешенством? Это удача, мистика, предвиденье? Я не понимаю!

— Это наука. Физике надо было в школе учиться, в своё время, а не всякую похабщину в учебниках рисовать, — тихо ответил Созон Иванович.

— А вот сейчас и проверим, твою науку, — злорадно пообещал голос и приказал:

— Поворачивай свою катапульту.

*****

Созон Иванович был уверен, что загадочный киллер убъёт его после того, как тот выполнит его приказание и потому, он, сразу как только прыгнул на доску и отправил в полёт кирпич, метнулся в сторону и специально упал плашмя прижавшись животом и головой к липкой кровле. По его быстрым расчётам именно там находилось слепое пятно образовавшееся вследствие небольшого перепада высот на крыше. При этом он так и не сбросил звонок и продолжал держать телефон в правой руке. Он хотел услышать как киллер начнёт ругаться, а затем ему придётся бросить свою точку и идти искать новую, что позволило бы выиграть время для побега. И неизвестный действительно начал ругаться, а потом произошло то, чего Созон Иванович действительно не мог предсказать.

Загрохотало. Он едва не оглох.

Созон Иванович было подумал, что киллер решил с ним не церемониться и применил гранатомёт, но когда перевернулся на спину увидел, что из-за края крыши вверх поднимается купол воздушного шара. И выглядело это необычайно зловеще поскольку цвет у воздушного шара был странный: чёрный пополам с красным и во все стороны от него летели жирные хлопья сажи. Только спустя мгновение показавшееся ему вечностью до него дошло, что это вовсе не шар, а дымная шапка появившаяся в результате сильного взрыва. А спустя другое мгновение, он понял что это его шанс выжить ибо огненно-дымная туча отделила одно здание от другого и сейчас, самое время было драпать.

— Твою мать! Созон! Это всё ты! Что ты сделал, сука!

Это очнулся в руке телефон, но Созон не слушал, он торопился добежать до спасительной будки откуда нырнул на лестницу, спустился, внизу подобрал свой саквояж и уже там, отдышавшись, сбросил звонок. Несколько успокоившись, он собрал в кулак всю свою волю и принялся устранять все возможные следы своего пребывания на тех-этаже. Все двери были тщательно закрыты, а ключи он отнёс уборщице как и обещал, после чего посетил туалет где почистился, умылся, проверил пропуск и нацепив самое равнодушное лицо отправился в вестибюль. Скрываться не имело никакого смысла. Ангел-хранитель знает его в лицо, а вот он про него ничего не знает. Зато теперь все будут знать, что Созон промазал. Так что же теперь делать? Уезжать из города? А может снова в часовщики? Опыт-то не пропьёшь. Но как же по-детски обидно. Опозорили. И кто? Ладно бы менты, но свои же...Да какие они свои, обычные гомосеки-завистники.

С этими мыслями он добрался до первого этажа где заметил метавшегося в дверях старика вахтёра. Тот очень хотел покинуть свой пост, хотел кому-то звонить и даже бежать за огнетушителем, а ещё у каждого входящего он с жаром интересовался - ну, что там?!!

Действительно, что там? Созон бросил вахтёру пропуск и миновав турникет очутился в дверях, откуда начиналась толпа любопытных и зевак наблюдавших за тем как на другой стороне улицы горит бензовоз, автобус и ещё какая-то длинная машина издали похожая на лимузин. Движение на улице было остановлено в обе стороны. Ревели пожарные машины, кто-то наглый пытался под шумок проехать почти вплотную к огню. Полицейские не успевали свистеть и выписывать штрафы.

— С эстакады бензовоз упал, — уверенно говорил кто-то.

— Так эстакада вон где, как он тут оказался? — возражали в толпе.

— Сам видел, он упал и проехал ещё на скорости, а потом в автобус вписался а автобус боком, вон в ту тачку. И как полыхнёт!

— Там живых точно не осталось.

— Пиздец, а не смерть.

Созон Иванович поглядел в сторону эстакады и похолодел от страха. Вот оно, то самое. "Орех, орех - на кого укажет грех". Грёбаный киллер. Кирпич угодил в бензовоз, тот резко свернул и упал вниз, а потом произошла детонация. Ну, тут уже следствие будет в точности разбираться. А ему уже ничего не остаётся. Только наверное, уезжать.

Протолкавшись сквозь толпу он побрёл вниз по улице, хмуро поглядывая на своё отражение мелькавшее в магазинных витринах. Какая же у него отвратительная рожа. Особенно вот тут у зеркальной витрины магазина музыкальных инструментов. Не человек, а чёрт. Скорее бы уже в ад забрали, а то на земле даже киллеры и те над ним потешаются.

Не отдавая себе отчёта он открыл дверь и зашёл в магазин где стал бесцельно бродить между стеллажей с инструментами. Мрачный молодой продавец с кольцом в носу, поглядывал на него словно кошка на ворону. Ходит туда сюда и чего спрашивается ходит?

— Может вы местом ошиблись? — предположил он. — Магазин "Шестёрочка", через два дома.

В этот момент в кармане у Галкина булькнул телефон оповещая о принятом сообщении. Подслеповато щурясь, Созон Иванович прочитал сообщение и горестно застонал.

— Здесь не аптека, — предупредил продавец. — У нас инструменты.

— Знаю... Струна для гитары, — пряча глаза отрешённо пробормотал Созон. — Какие бывают струны?

— Всякие. Ми, Си, Соль, Ре, Ля, — сказал продавец. — Вам на какую гитару?

— Ля? Как мило. Дайте мне струну, ля, — попросил Созон.

— Только одну?

— Да. Мне хватит. И ещё вон те перчатки, они с виду крепкие.

Разжившись гитарной струной и перчатками барабанщика он вышел на улицу. Отступать более не имело смысла. Нужно идти охотиться на киллера. И причин этому было две. Первая - заказчик перевёл деньги за клиента, а это значит что клиент мёртв и то что от него осталось сейчас догорает неподалёку от бензовоза, а вторая... Он вспомнил про щелчки во время телефонного разговора с неизвестным. Это часы. Причём необычайно редкая модель Кайзер с циферблатом в виде солнечной системы. Он наверняка где-то тут. Шныряет в толпе. Вот по часам-то Созон его и вычислит. Ничего, ничего страшного. Задача трудная, но ради таких трудных задач он и живёт, а иначе и жить незачем.

-----------

автор Василий Кораблев

Осторожно, попутчик!

Thu, 15 Jan 2026 13:36:32 +0300

Товарищи ЯПовчане, всем доброго дня и лучей радости.

Сегодня утром, по пути в Дмитров, подобрал с обочины неистово голосующего мужика славянской внешности, ибо есть во мне немного сострадания к бедолагам на дороге.

Попросил подкинуть его до Сухарево за пятихатку, что по прямой и недалеко, которую сразу после посадки и положил на подлокотник. Посадил сзади, ибо спереди хабар свой лежал.

Проехали буквально пару километров, и тут вижу направленную в мою сторону активную жестикуляцию чёрно-белой палкой сотрудника ГИБДД.

Останавливаюсь, выхожу из машины, задаю удивленный вопрос:" С чего это вы так активно меня решили остановить, ведь ехал без превышения, машина чистая, все пристёгнуты?" И тут на первый план выходит сотрудник административо-транспортного контроля в схожей с гайцом цветографической форме, представляется и сразу спрашивает, кого я везу в салоне. Отвечаю, что мужик мёрз на обочине, попросил подкинуть недалеко. Тут всё и завертелось: пассажир сказал, что договорился со мной за 500р, деньги отдал и всё такое, всё снимается на кучу камер( к этому моменту подошли ещё 2 сотрудника Диптранса, чела уводят в машину Диптранса для дачи показаний, на меня заводят 3 административки, в том числе за незаконное оказание транспортных услуг и прочее, чел(100% подсадной) на момент составления протоколов в отношении меня, аккуратно исчезает.

В итоге, мой автомобиль отправляется на спецстоянку до следующего четверга, это 1520р/день+8000р штрафа, учитывая скидку.

Сказать, что я в ахуе-ничего не сказать. На пустом месте поднял себе проблем...

Да, сам себе злобный сами знаете кто, но, блеадь! Это же новый уровень сбора бабла с населения. А что делать жителям глухомань, где автобус, в лучшем случае, ходит пару раз в день, и люди вскладчину добираются до мест?

Как мне сказал сотрудник Диптранса, идёт массовая работа по стране со всеми агрегаторами, включая "блабла", "попутчик", "овито", каршеринг и прочее.

В общем, будьте бдительны, товарищи.

Thu, 15 Jan 2026 13:36:32 +0300

Товарищи ЯПовчане, всем доброго дня и лучей радости.

Сегодня утром, по пути в Дмитров, подобрал с обочины неистово голосующего мужика славянской внешности, ибо есть во мне немного сострадания к бедолагам на дороге.

Попросил подкинуть его до Сухарево за пятихатку, что по прямой и недалеко, которую сразу после посадки и положил на подлокотник. Посадил сзади, ибо спереди хабар свой лежал.

Проехали буквально пару километров, и тут вижу направленную в мою сторону активную жестикуляцию чёрно-белой палкой сотрудника ГИБДД.

Останавливаюсь, выхожу из машины, задаю удивленный вопрос:" С чего это вы так активно меня решили остановить, ведь ехал без превышения, машина чистая, все пристёгнуты?" И тут на первый план выходит сотрудник административо-транспортного контроля в схожей с гайцом цветографической форме, представляется и сразу спрашивает, кого я везу в салоне. Отвечаю, что мужик мёрз на обочине, попросил подкинуть недалеко. Тут всё и завертелось: пассажир сказал, что договорился со мной за 500р, деньги отдал и всё такое, всё снимается на кучу камер( к этому моменту подошли ещё 2 сотрудника Диптранса, чела уводят в машину Диптранса для дачи показаний, на меня заводят 3 административки, в том числе за незаконное оказание транспортных услуг и прочее, чел(100% подсадной) на момент составления протоколов в отношении меня, аккуратно исчезает.

В итоге, мой автомобиль отправляется на спецстоянку до следующего четверга, это 1520р/день+8000р штрафа, учитывая скидку.

Сказать, что я в ахуе-ничего не сказать. На пустом месте поднял себе проблем...

Да, сам себе злобный сами знаете кто, но, блеадь! Это же новый уровень сбора бабла с населения. А что делать жителям глухомань, где автобус, в лучшем случае, ходит пару раз в день, и люди вскладчину добираются до мест?

Как мне сказал сотрудник Диптранса, идёт массовая работа по стране со всеми агрегаторами, включая "блабла", "попутчик", "овито", каршеринг и прочее.

В общем, будьте бдительны, товарищи.

Грибная икра из замороженных лисичек

Thu, 15 Jan 2026 17:08:19 +0300

Рукожопства пост. Об окончании сообщу (7 фото)

Осень в этом году была щедрая на грибы, много заготовили впрок и заморозили. И вот сегодня я нашла в холодильнике замороженные отварные лисички и решила сделать грибную икру для бутербродов. А что еще на удаленке в рабочий день делать?

Для икры подходят любые свежие или замороженные грибы. Самой вкусной она получается из белых.

Итак, рецепт.

На 1 кг грибов

150 гр моркови

150 гр репчатого лука

50 мл растительного масла

3/4 чайной ложки соли

1/4 чайной ложки молотого черного перца

1 ст. ложка 9% уксуса

Thu, 15 Jan 2026 17:08:19 +0300

Рукожопства пост. Об окончании сообщу (7 фото)

Осень в этом году была щедрая на грибы, много заготовили впрок и заморозили. И вот сегодня я нашла в холодильнике замороженные отварные лисички и решила сделать грибную икру для бутербродов. А что еще на удаленке в рабочий день делать?

Для икры подходят любые свежие или замороженные грибы. Самой вкусной она получается из белых.

Итак, рецепт.

На 1 кг грибов

150 гр моркови

150 гр репчатого лука

50 мл растительного масла

3/4 чайной ложки соли

1/4 чайной ложки молотого черного перца

1 ст. ложка 9% уксуса

Красотки из Сети 14.01.2026.

Wed, 14 Jan 2026 10:57:45 +0300

Небольшая подборка симпатичных Дам, 50 фото.

Wed, 14 Jan 2026 10:57:45 +0300

Небольшая подборка симпатичных Дам, 50 фото.

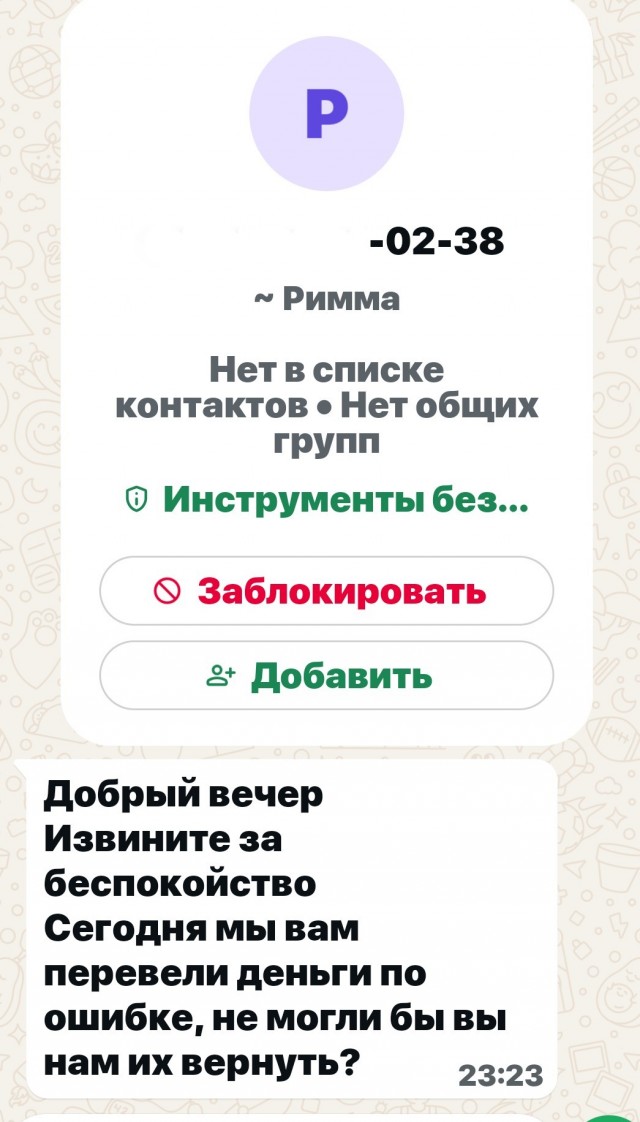

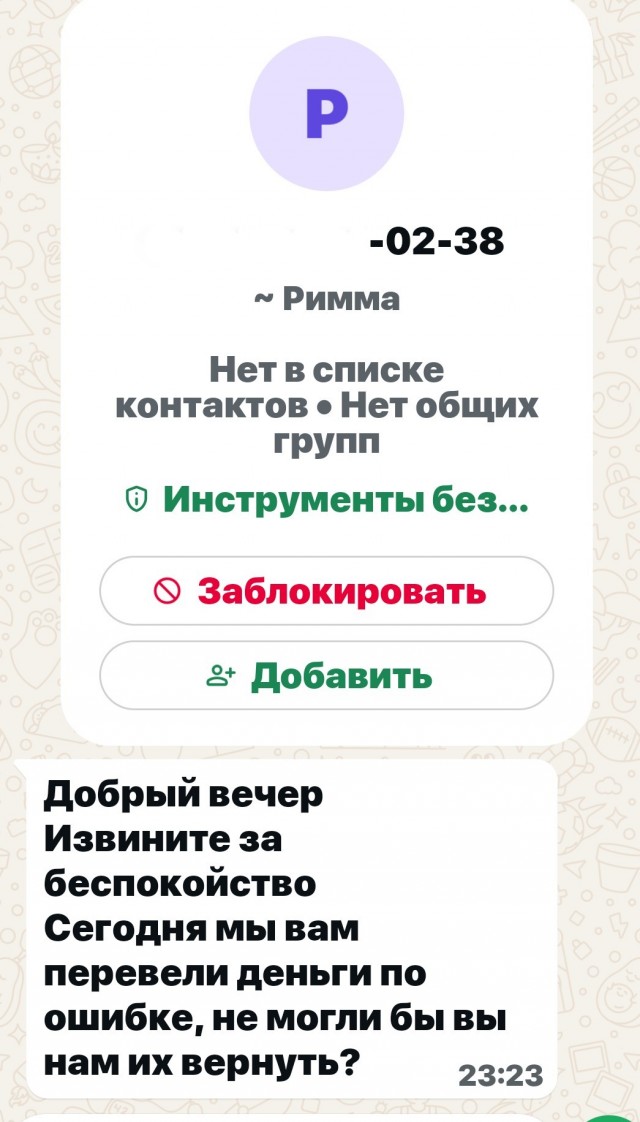

Какой-то мутный схематоз.

Wed, 14 Jan 2026 07:56:16 +0300

Ситуация такая- вчера вечером чото брякало в телефоне но я был занят и не смотрел, завалившись спать посмотрел и слегка напрягся- в вотсапе сообщение от некой Риммы.

Wed, 14 Jan 2026 07:56:16 +0300

Ситуация такая- вчера вечером чото брякало в телефоне но я был занят и не смотрел, завалившись спать посмотрел и слегка напрягся- в вотсапе сообщение от некой Риммы.

Хотите как в США?

Wed, 14 Jan 2026 09:12:19 +0300

В США, если купить новый телевизор и уложить старый сломаный в коробку от нового, заботливый человек придет и утилизирует его за вас.

Вера в человечество еще жива.

Wed, 14 Jan 2026 09:12:19 +0300

В США, если купить новый телевизор и уложить старый сломаный в коробку от нового, заботливый человек придет и утилизирует его за вас.

Вера в человечество еще жива.

Кому погода плохая, а кому-то Погода для искусства..

Tue, 13 Jan 2026 21:49:35 +0300

Как он это сделал?

Красавец,слов нет...

Tue, 13 Jan 2026 21:49:35 +0300

Как он это сделал?

Красавец,слов нет...

Осторожно, ИИшница!

Wed, 14 Jan 2026 08:25:37 +0300

Один из пользователей интернета обратился к ИИ с просьбой отретушировать снимок, сделанный в его первый класс советской школы. Вот какой результат вышел

Wed, 14 Jan 2026 08:25:37 +0300

Один из пользователей интернета обратился к ИИ с просьбой отретушировать снимок, сделанный в его первый класс советской школы. Вот какой результат вышел

Это Персик. Он теперь будет жить с нами.

Tue, 13 Jan 2026 10:52:24 +0300

Недавно ушёл мой кот, которому было 18 лет и 4 месяца. В позапрошлом (2024) году ушла кошка. Ей было 18 и 1. Посты про них я уже пилила, когда они были ещё живы, да и фотки по вторникам стабильно выкладывала. Они навсегда будут в моем сердце. Найдены они были ещё котятами и прожили долгую и счастливую котожизнь.

А вот у моего сына никогда не было котёнка. Ему 13,то есть коты были уже взрослыми когда он появился. И он начал просить котёнка. Ну и как говорится, без кота и жизнь не та. Очень хотела рыжего и назвать Василием, но Авито, как назло, не баловал объявлениями о раздаче рыжих котов.

Нашли единственного - этого. Ещё когда смотрели фотки понимала что это нифига не Василий. Скинула фотки крестной, она сразу говорит - это Персик. Сын одобрил. Когда ехали с ним домой, он сидел у сына за пазухой. И, наверное от стресса, пометил его. Выбрал себе главного раба. Так и есть, когда сын дома - не отходит от него.

Первый день носили его на лоток каждый час - все понял, на следующий день начал уверенно туда сам ходить. На кухне только тупит немного, приходит, начинает орать, а миску не видит, пока не ткнешь, но думаю, тоже скоро освоит. Цветы на подоконниках не жрёт - тоже плюс, а то скоро рассада) В общем наумнейший кот.

Добро к нам пожаловать!

Tue, 13 Jan 2026 10:52:24 +0300

Недавно ушёл мой кот, которому было 18 лет и 4 месяца. В позапрошлом (2024) году ушла кошка. Ей было 18 и 1. Посты про них я уже пилила, когда они были ещё живы, да и фотки по вторникам стабильно выкладывала. Они навсегда будут в моем сердце. Найдены они были ещё котятами и прожили долгую и счастливую котожизнь.

А вот у моего сына никогда не было котёнка. Ему 13,то есть коты были уже взрослыми когда он появился. И он начал просить котёнка. Ну и как говорится, без кота и жизнь не та. Очень хотела рыжего и назвать Василием, но Авито, как назло, не баловал объявлениями о раздаче рыжих котов.

Нашли единственного - этого. Ещё когда смотрели фотки понимала что это нифига не Василий. Скинула фотки крестной, она сразу говорит - это Персик. Сын одобрил. Когда ехали с ним домой, он сидел у сына за пазухой. И, наверное от стресса, пометил его. Выбрал себе главного раба. Так и есть, когда сын дома - не отходит от него.

Первый день носили его на лоток каждый час - все понял, на следующий день начал уверенно туда сам ходить. На кухне только тупит немного, приходит, начинает орать, а миску не видит, пока не ткнешь, но думаю, тоже скоро освоит. Цветы на подоконниках не жрёт - тоже плюс, а то скоро рассада) В общем наумнейший кот.

Добро к нам пожаловать!

Я сегодня несмотря на понедельник, на работу не пошел. Выходные продолжаются.

Mon, 12 Jan 2026 20:37:13 +0300

Купил я намедни скородочку. Сковородочка не простая, а с гранитным покрытием. Это вам не лось пукнул!

Сходил на колхозное поле, картошечки под снегом накопал из-под снега, лучку также.

Почистил её, порезал меленько да и на свородку - хрясь! И давай её жарить, родимую.

И пожарил.

Mon, 12 Jan 2026 20:37:13 +0300

Купил я намедни скородочку. Сковородочка не простая, а с гранитным покрытием. Это вам не лось пукнул!

Сходил на колхозное поле, картошечки под снегом накопал из-под снега, лучку также.

Почистил её, порезал меленько да и на свородку - хрясь! И давай её жарить, родимую.

И пожарил.

Звёздные войны IV: кто убил опекунов Люка Скайуокера?

Tue, 13 Jan 2026 01:47:58 +0300

Обзор состоит из нескольких частей, просьба не ломать, об окончании сообщу, спасибо.

Поклонники франшизы «Звёздные войны», должно быть, помнят, как в четвёртом (начальном, первом по счёту) эпизоде Люк Скайуокер возвращается на ферму, где жил со своими опекунами, и обнаруживает тех мёртвыми возле дымящегося дома. Поистине драматический момент.

Tue, 13 Jan 2026 01:47:58 +0300

Обзор состоит из нескольких частей, просьба не ломать, об окончании сообщу, спасибо.

Поклонники франшизы «Звёздные войны», должно быть, помнят, как в четвёртом (начальном, первом по счёту) эпизоде Люк Скайуокер возвращается на ферму, где жил со своими опекунами, и обнаруживает тех мёртвыми возле дымящегося дома. Поистине драматический момент.

Отвлекитесь на три минуты и погрузитесь в этот музыкальный шедевр

Tue, 13 Jan 2026 07:09:13 +0300

наполненный напряжением, чувствами и искренними эмоциями.

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36

Tue, 13 Jan 2026 07:09:13 +0300

наполненный напряжением, чувствами и искренними эмоциями.